回答哲学问题的大型语言模型

近年来,计算机科学家一直在尝试创建越来越先进的对话和信息系统。ChatGPT和其他高性能语言模型的发布展示了人工智能在回答用户问题、编写文本和与人类交谈方面可以走多远。

加州大学河滨分校、巴黎高等师范学院(ECN)和慕尼黑路德维希-马克西米利安大学的研究人员开发了一种大型语言模型,可以用特定哲学家的声音回答哲学问题。这个模型在预印本服务器arXiv上发表的一篇论文中提出,可以自主生成与人类哲学家非常相似的答案。

“Anna Strasser,Matthew Crosby和我注意到人们正在以各种作家或其他哲学家的风格创建GPT-3输出,”进行这项研究的研究人员之一Eric Schwitzgebel告诉Tech Xplore。“我们认为看看我们是否可以在哲学家的作品上微调GPT-3(生成预训练转换器3)会很有趣,然后问它问题,看看它是否说了真正的哲学家可能说过的话。

研究人员决定使用GPT-3,这是OpenAI创建的模型,支持ChatGPT的功能。最初,他们在康德的文本上训练了这个模型,然后在施维茨格贝尔的博客上,名为“旋转的心灵”,最后,在他的授权下,在美国哲学家丹尼尔丹尼特的大部分作品上。

“我们决定,看看专家们是否可以将微调后的模型与Dennett对相同问题的回答区分开来,这将是一件有趣的事情,”Schwitzgebel说。“Matt不得不离开这个项目,所以我们带了我的儿子David Schwitzgebel,他是巴黎ENS的认知科学研究生。

GPT-3 是一种自回归语言模型,它使用深度学习来生成文本。该模型基本上预测句子或单词序列中的下一个单词,采用复杂而强大的统计技术。

“例如,假设我说,'我要带我的妻子去浪漫旅行',然后让你猜下一个词,”Schwitzgebel解释说。“大概你更有可能回答'巴黎',而不是'垃圾'或'黄色'——当然,这句话可以用各种方式完成。GPT-3 使用庞大的文本语料库检查一个句子的整个先前上下文(最多数百个单词),然后统计猜测下一个单词。它这样做不是因为它'知道'巴黎是浪漫的,而是因为在庞大的语言使用数据库中,它会在'巴黎'之前看到像'浪漫'和'旅行'这样的词比在'垃圾'之前更频繁地出现。

作为他们最近研究的一部分,Schwitzgebel和他的同事对Dannett过去的作品进行了微调GPT-3。换句话说,他们进一步训练了哲学家文本上的模型,以确保在预测句子中的下一个单词时,它比其他单词使用模式更重视丹尼特的典型单词使用模式。

“我特别惊讶的是,考虑到Dennett的答案和四个非挑选的GPT-50输出,专家们只能正确猜测3%的时间,这比20%的机会率要好,但远不及我们假设的80%,”Schwitzgebel说。“非精选意味着我们没有尝试选择好的输出。我们只是采用了满足一些机械标准的第一批输出。这表明,GPT-3的微调模型可以令人惊讶地接近于以特定哲学家的声音说话。

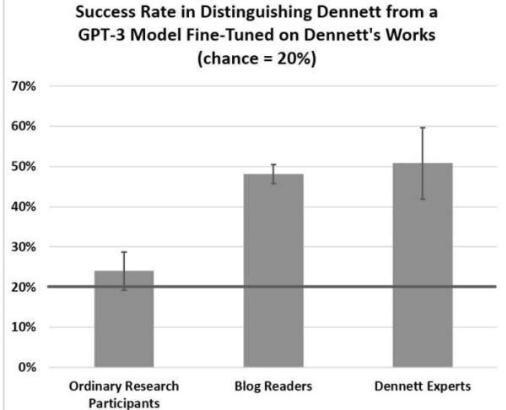

为了评估他们称之为“Digi-Dan”的模型,研究人员询问了425名人类用户,他们是否可以区分模型生成的哲学问题的答案和Dennett产生的其他问题的答案。值得注意的是,他们发现专家哲学家和哲学博客读者可以在大约50%的时间内识别哲学家的答案,而对哲学一无所知或知之甚少的普通参与者在大约20%的时间内识别出丹尼特的答案。

这些发现表明,“DigiDan”产生的文本有时会被误认为是哲学家写的文本,但仍有改进的余地。未来,Schwitzgebel和他的同事计划继续研究他们的模型,并探索其可能的实际实现。

“我们现在开始考虑这可能产生的社会后果及其作为工具的潜力,”Schwitzgebel补充道。“例如,哲学家能否在自己的作品上微调模型,然后将其输出用作思想来源?哲学史家能否创造一个哲学家的模型,然后问它历史哲学家从未被问过的问题?在这一点上,我们不能相信输出是可靠的,但它们至少可能是暗示性的和发人深省的。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

安徽淮南地区的长安汽车经销商近期对2025款启源Q05车型的市场策略进行了调整,以进一步吸引消费者。作为长安汽...浏览全文>>

-

近年来,豪华SUV市场持续升温,而作为大众旗下的高端品牌,途锐凭借其卓越的性能与豪华配置,一直深受消费者的...浏览全文>>

-

在新能源汽车市场中,一汽-大众ID 4 CROZZ凭借其出色的性价比和丰富的配置吸引了众多消费者的关注。作为一款...浏览全文>>

-

近年来,随着国内汽车市场的快速发展,越来越多的消费者开始关注性价比高的小型车。QQ多米作为一款备受关注的...浏览全文>>

-

在当今的汽车市场中,选择一款高性价比的车型是许多消费者的重要考量。对于追求品质与经济平衡的购车者来说,...浏览全文>>

-

阜阳地区消费者对上汽大众途岳的关注度一直很高,尤其是2025款途岳的上市更是引发了广泛关注。作为一款紧凑型S...浏览全文>>

-

天津滨海长安猎手K50作为一款备受关注的车型,在市场上拥有较高的关注度。这款车型以其出色的性能和合理的价格...浏览全文>>

-

近年来,随着新能源汽车的普及,插电混动车型因其兼顾燃油经济性和驾驶性能的特点,受到了越来越多消费者的青...浏览全文>>

-

途观X作为上汽大众旗下的高端轿跑SUV车型,凭借其时尚动感的外观设计和丰富的科技配置,在市场上一直备受关注...浏览全文>>

-

在选择SUV车型时,上汽大众途昂凭借其宽敞的空间和强大的性能成为不少消费者的首选。对于蚌埠地区的消费者来说...浏览全文>>

- 天津滨海长安猎手K50多少钱 2025款落地价,最低售价18.29万起,赶紧行动

- 天津滨海ID.4 CROZZ 2025新款价格,买车省钱秘籍

- 安徽淮南途昂X多少钱?性价比超高的选车秘籍

- 福特领睿试驾,开启完美驾驭之旅

- 比亚迪海豹05DM-i试驾预约流程

- 凯迪拉克CT5预约试驾,从预约到试驾的完美旅程

- 滁州途观X落地价,各配置车型售价全知晓

- 极狐 阿尔法T6试驾,开启完美驾驭之旅

- 长安欧尚520试驾操作指南

- QQ多米试驾需要注意什么

- 长安Lumin试驾,感受豪华与科技的完美融合

- 安庆长安猎手K50最新价格2025款与配置的完美平衡

- 池州迈腾GTE最新价格2022款全解,买车必看的省钱秘籍

- 安徽亳州ID.6 X多少钱?购车全攻略来袭

- 五菱雪宝试驾,开启豪华驾驶之旅

- 马自达EZ-6预约试驾,新手必看的详细流程

- 安徽亳州T-ROC探歌落地价实惠,配置丰富,不容错过

- 滁州高尔夫GTI价格大揭秘,买车前必看

- 东莞威然落地价,最低售价22.99万起优惠不等人

- 试驾王牌M7,体验豪华驾乘的乐趣